Subtítulos inmersivos. Informe final del grupo de trabajo del WAI-W3C "Immersive Captions Community Group"

Captura del immersive captions prototyping tool de Chris Hughes de la Universidad de Salford

Desde el Immersive Captions Community Group del WAI-W3C es una satisfacción poder anunciar la publicación del informe final de subtítulos inmersivos "Recommendations for accessible captions in 360 degree video".

Las experiencias inmersivas, como la realidad virtual o la realidad aumentada, se están generalizando y debemos difundir la importancia de la accesibilidad en todas las tecnologías emergentes. Este documento se centra en los subtítulos en los vídeos inmersivos de 360 grados, con el objetivo de que la experiencia del espectador sordo o con problemas de audición sea más igualitaria.

Resumo a continuación los puntos más relevantes del documento.

Índice:

- Qué debe mostrarse en los subtítulos

- Identificación del hablante

- Comunicar de dónde proviene el audio

- Diferentes modos de subtítulos: Interactive Captions (IC) y Transcript View

- Subtítulos anclados o no al orador

- Usabilidad e interfaz de usuario

- Visualización y formato de los subtítulos

- Consideraciones físicas

- Hacia dónde nos dirigimos

Otros artículos de Olga Carreras sobre accesibilidad en VR (Realidad Virtual)

Alcance: qué debe mostrarse en los subtítulos

Los subtítulos en realidad virtual deben abarcar el habla y todos los sonidos, de este modo, las personas sordas o con problemas de audición podrán percibir, comprender y participar plenamente en la experiencia, en la misma medida que los demás.

Por una parte, deben incluir la voz localizada de un hablante identificado (humano o no) y la voz no localizada, como los audios de tipo voice of god.

Por otra parte, deben incluir todos los sonidos espaciales, incluidos:

- los sonidos de objetos inanimados (como armas, electrodomésticos, etc.)

- los sonidos de objetos animados (como pasos, sonidos de animales, etc.)

- el sonido ambiente puntual (sonido ambiente espacializado diegético(1), como un río cercano)

- sonido ambiente circundante (sonido ambiente no espacializado diegético(1), como una multitud)

- sonido de música (música de fondo no diégetica)

(1) Diegético: todo lo que está ocurriendo en la escena y que los personajes oyen. No diegético (o extradiegético): lo que no oyen los personajes, como la música incidental o las narraciones en off.

Identificación del hablante

En un entorno inmersivo es muy probable que no estés mirando hacia la fuente del sonido. Por ello, es fundamental tener indicadores para identificar al hablante y la ubicación del audio y, de este modo, ayudar a igualar la experiencia de todos los usuarios.

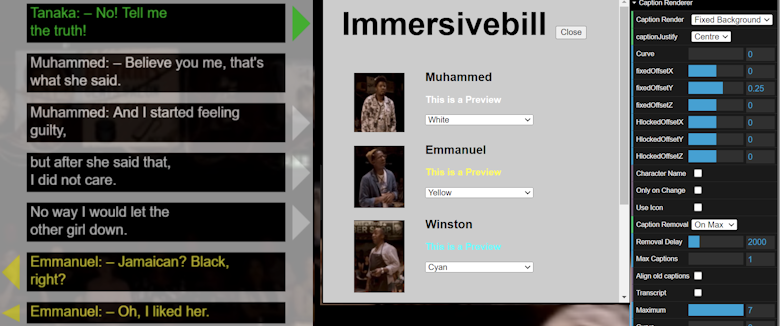

Hay diferentes métodos para distinguir a los hablantes, como incluir su nombre, su icono o imagen, o asociarles un color diferente. El uso del color siempre será una técnica adicional a las demás, porque requiere, por una parte, que los usuarios recuerden los colores y, por otra, que puedan diferenciar dichos colores.

Le agradecemos a Chris Hughes, de la Universidad de Salford, la herramienta libre de prototipado de subtítulos inmersivos (immersive captions prototyping tool) que permite configurar con mucho detalle los subtítulos para hacer diferentes pruebas, entre ellas, que se muestre la imagen y/o el nombre del orador o asignarle un color.

Captura del immersive captions prototyping tool de Chris Hughes de la Universidad de Salford

En la imagen anterior, cada subtítulo va precedido del nombre del personaje y tiene un color asignado.

En la siguiente imagen, cada subtítulo tiene además asociada la imagen del personaje:

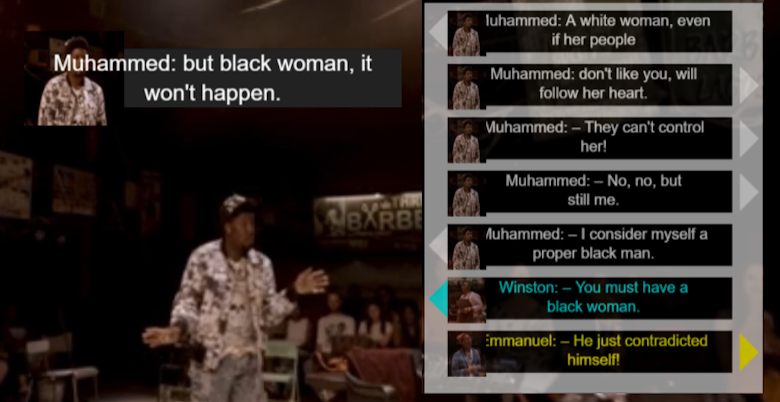

Captura del immersive captions prototyping tool de Chris Hughes de la Universidad de Salford

Por último, para que la experiencia sea similar para todas las personas, evita hacer spoilers en los subtítulos, como anunciar la llegada de un personaje antes de que ocurra.

Comunicar de dónde proviene el audio

Una solución para comunicar de dónde proviene un audio específico es el uso de flechas guía, que señalan la ubicación del audio, del personaje que habla o del objeto que hace ruido. En los ejemplos anteriores, cada subtítulo tiene asociada una flecha.

Podrían usarse diferentes flechas para identificar diferentes personajes o fuentes de sonido. Además, el tamaño y la ubicación de las flechas podrían usarse para indicar la distancia relativa a la fuente.

Ten en cuenta que hay que indicar y ubicar el sonido que proviene de cualquier lugar, no solo el que está en el campo de visión actual del usuario.

Esta información podría sobrecargar el contenido principal, así que una opción sería tenerla habilitada por defecto, pero poder desactivarla.

Diferentes modos de subtítulos: Interactive Captions (IC) y Transcript View

Subtítulos interactivos

Los subtítulos interactivos proporcionan unos segundos de conversación subtitulada que se puede usar como navegación basada en diálogos.

Estarían a medio camino entre los subtítulos tradicionales, que permanecen pocos segundos en pantalla, y una transcripción completa, que resulta muy útil para los usuarios sordociegos, pero que puede ser demasiado larga para mostrarla en pantalla o que haya dificultades para comunicar en ella el sonido espacial.

Subtítulos interactivos. Captura del immersive captions prototyping tool de Chris Hughes de la Universidad de Salford

Gracias a los subtítulos interactivos, las personas pueden seguir la conversación de una manera menos apresurada y en más de una línea de subtítulos a la vez.

En una vista de 3 a 7 líneas de subtítulos puedes mostrar claramente la identificación única del orador y su ubicación relativa, mediante el uso de triángulos que apuntan hacia la persona, como se observa en la imagen anterior.

Ralentizar la reproducción facilita el seguimiento de los subtítulos, por lo que podría dejarse a una velocidad de reproducción del 75%, pero que el usuario pueda ajustarla según sus necesidades.

El usuario podría buscar hacia adelante y hacia atrás por texto en lugar de por tiempo, para saltar al momento en el que ocurrió ese subtítulo específico.

En la siguiente imagen se muestran los botones de subtítulo siguiente y subtítulo anterior de la herramienta de prototipado de subtítulos inmersivos, que te permiten moverte entre los subtítulos, lo cual, combinado con los subtítulos interactivos, ayuda a llegar a una sección del vídeo de forma sencilla y con una pulsación simple.

Botones de subtítulo siguiente y subtítulo anterior. Captura del immersive captions prototyping tool de Chris Hughes de la Universidad de Salford

Vista de transcripción

La vista de transcripción es una vista desplazable de todo el diálogo y los sonidos clave del vídeo.

Las transcripciones son útiles para consumir el contenido a través de otras tecnologías, como una línea braille para usuarios sordociegos o un lector de pantalla para personas ciegas o con baja visión.

La transcripción siempre debe estar disponible por separado para facilitar el acceso con la línea braille, pero también puede integrarse en la interfaz de usuario del vídeo.

La transcripción debe estar bien formateada, con una identificación clara del hablante y dividida en párrafos de tamaño razonable.

La vista de transcripción podría modificarse para que fuera interactiva, pero al mismo tiempo debe ser fácil de manejar y configurar.

Subtítulos anclados o no al orador

En términos de visualización, el grupo prefirió que los subtítulos persistan dentro del campo de visión del usuario, lo que permite a las personas sordas o con problemas de audición atender a lo que se dice y se oye mientras miran a su alrededor.

En nuestro grupo, a algunas personas les gustaba que los subtítulos estuvieran anclados a la cabeza, mientras que otros preferían tenerlos fijos para saber dónde mirar para encontrarlos o para evitar molestias físicas. Los subtítulos que se mueven pueden provocar mareos en algunas personas, por lo que necesitan poder limitar el movimiento visual de los mismos.

Experimentamos con una función de anclaje de subtítulos que mostraba los subtítulos junto al orador y seguía al orador a lo largo del video. Si bien agregar demasiados componentes móviles a un medio podría resultar abrumador, algunas personas en nuestro grupo querían una opción para anclar los subtítulos al hablante en lugar de mover los subtítulos con el campo de visión del usuario. La practicidad de esta función puede variar según el tipo de contenido y la cantidad de movimiento.

En resumen, la clave es permitir la máxima flexibilidad. El usuario debe tener la capacidad de personalizar los subtítulos y ajustarlos a sus necesidades personales de manera sencilla y accesible.

Usabilidad e interfaz de usuario

La interfaz de usuario debe permitir activar de forma sencilla cada uno de los controles y configuraciones, como la capacidad de habilitar y deshabilitar tanto los subtítulos como el modo de subtítulos interactivos.

También debe permitir personalizar:

- la fuente y el tamaño letra;

- el color de la fuente y el color de fondo sobre el que se muestran los subtítulos;

- la velocidad de reproducción (1,0x, 0,75x y 0,5x);

- la identificación del hablante mediante el uso de texto, iconos y colores;

- el número de líneas;

- la duración del tiempo de visualización o la cantidad de subtítulos que pueden permanecer en la pantalla al mismo tiempo

- el anclaje de los subtítulos para evitar mareos.

La configuración debería ser fácil de localizar y ajustar, y las opciones deberían estar en agrupaciones lógicas e intuitivas.

Visualización y formato de los subtítulos

Los subtítulos deben seguir las pautas de las normativas existentes que tratan aspectos como el contraste del color, el tamaño del texto, su ubicación o su correcta sincronización.

[Nota Olga: por ejemplo, en España tenemos la norma UNE 153010:2012 Subtitulado para personas sordas y personas con discapacidad auditiva.]

Hay que tener en cuenta que leer subtítulos cuando hay varios oradores puede ser un gran desafío, porque los oradores pueden turnarse rápidamente en cualquier orden. Esto es especialmente cierto en los vídeos inmersivos, donde el espectador tiene un control total de su campo de visión, pero puede no saber dónde centrar su atención.

El lector de subtítulos generalmente se concentra en leer los subtítulos y no puede anticipar quién hablará a continuación. Como resultado, el lector suele mirar de un lado a otro entre los subtítulos y los oradores, lo cual cansa, distrae y puede hacerte sentir excluido de la conversación.

Consideraciones físicas

Trastornos vestibulares

Los trastornos vestibulares afectan a muchas personas, entre ellas a un alto porcentaje niños sordos y con problemas de audición. Para estas personas, las experiencias inmersivas pueden resultar un desafío donde, el movimiento adicional de los subtítulos, incluidos los subtítulos bloqueados, no ayuda precisamente.

Para asegurar la mejor experiencia de usuario, se debe permitir a las personas que tengan el control sobre cualquier movimiento.

Procesamiento mental

La comprensión de la información audiovisual requiere el procesamiento mental de la información auditiva y visual, así como de las conexiones entre ellas.

Las personas sordas y con problemas de audición a menudo tienen que elegir entre ver las imágenes o leer los subtítulos, y es muy probable que se pierdan información, porque rara vez hay tiempo suficiente para percibir y comprender ambos. En consecuencia, la información debe presentarse de tal manera que dé tiempo suficiente para procesar toda la información de manera eficaz.

Además, los espectadores suelen encontrar ruido visual, como interferencias en la línea de visión o una iluminación deficiente, que solo son una mera molestia para los usuarios oyentes, pero que es un problema significativo par las personas sordas o con problemas de audición.

Como ya hemos dicho, leer subtítulos cuando hay varios oradores puede ser un gran desafío para los lectores de subtítulos. El lector suele mirar de un lado a otro entre los subtítulos y los oradores, lo cual cansa, distrae y puede hacerte sentir excluido de la conversación.

En estos entornos, las personas con problemas de audición no consideran útiles los subtítulos tradicionales, que permanecen en una ubicación, aunque incluyan el nombre del hablante, porque no indican la localización de la persona que habla. Además, si el hablante se mueve, se crea una distancia entre la información visual y los subtítulos, lo que obliga al espectador a mover los ojos o la cabeza constantemente. Como resultado, se concentrará únicamente o en los subtítulos o en las imágenes.

Por último, ten en cuenta que las personas pueden utilizar los subtítulos para confirmar o corregir lo que escucharon. Para revisar la información hablada leyendo los subtítulos que se muestran durante varios segundos se suelen preferir varias líneas de subtítulos. Sin embargo, los espectadores que no escuchan el habla prefieren tener 2 o 3 líneas de texto para minimizar el tiempo de exploración de las palabras mientras leen.

Hacia dónde nos dirigimos

Si el objetivo es tener una interoperabilidad consistente para su uso en realidad virtual, habría que buscar una versión unificada de la especificación de subtítulos.

Una vez que hayamos acordado la especificación y cómo adaptarla a entornos de 360 grados, necesitamos tener un entorno de creación de código abierto que la admita. En este sentido, es de agradecer a Chris Hughes, de la Universidad de Salford, la herramienta de creación de prototipos de subtítulos inmersivos que permite explorar diferentes enfoques, formatos y estilos de subtítulos inmersivos.

Por supuesto, queremos compartir los hallazgos con académicos y con la industria, para explorar la integración en plataformas, dispositivos y sistema operativos de realidad virtual actuales, y recibir comentarios de los usuarios y de cualquier mente apasionada.

Artículos de Olga Carreras sobre accesibilidad en VR (Realidad Virtual)

- General - Diferentes discapacidades

- Accesibilidad en XR, metaverso accesible e inclusivo. Guía de accesibilidad en entornos de Realidad Virtual (VR), 2022

- Ejemplos de opciones de accesibilidad en entornos de realidad virtual (VR) 2023. Metaverso accesible e inclusivo, 2023

- Accesibilidad de formularios en entornos de realidad virtual. Metaverso inclusivo, 2023

- Discapacidad auditiva

- Análisis de aplicaciones VR concretas

- Probando las características de accesibilidad de Cosmonious High (Realidad Virtual), 2023

- Opciones de accesibilidad en un laboratorio de química en Realidad Virtual (VR), accesibilidad en entornos de aprendizaje , 2023

- Viajar en Realidad Virtual. Opciones de accesibilidad. Metaverso y turismo inclusivo, 2024

- Reseñas de libros

- Cursos, ponencias, congresos