Ejemplos de opciones de accesibilidad en entornos de realidad virtual (VR) 2023. Metaverso accesible e inclusivo.

En este artículo iré recopilando las entradas sobre accesibilidad en entornos de realidad virtual (VR) que voy publicando en redes sociales.

Última actualización: 20 de diciembre de 2023.

Si te interesa este tema te recomiendo el artículo de introducción: Accesibilidad en XR, metaverso accesible e inclusivo. Guía de accesibilidad en entornos de Realidad Virtual (VR). Puedes consultar todos los artículos que he publicado sobre accesibilidad en VR en artículos sobre Accesibilidad XR (VR/AR) / Metaverso / Videojuegos

Índice

- Lengua de signos estándar VR, marzo 2023

- Guía para personas ciegas y con baja visión en entornos de realidad virtual social, junio 2023

- Subtítulos y audiodescripciones, marzo 2023

- La importancia del contraste de las manos en XR, febrero 2023

- Migas de pan sonoras en Blind Burners de AltSpace, febrero 2023

- Seguimiento de manos en Meta Workrooms, febrero 2023

- Formularios en VR, marzo 2023

- Características de accesibilidad de Cosmonious High, septiembre 2023

- Opciones de accesibilidad en un laboratorio de química en Realidad Virtual (VR), accesibilidad en entornos de aprendizaje, diciembre 2023

Lengua de signos estándar VR

Si no puedes usar la lengua de signos en aquellos entornos en los que no hay seguimiento de manos o este no es suficiente, ¿por qué no crear una lengua de signos con los gestos predefinidos que se soportan?

Pues eso es lo que ha hecho una comunidad de VRChat. Esta semana he estado investigando la Lengua de signos estándar VR en VRChat, en concreto en los mundos "MrDummy_NL's Sign&Fun" y "Helping Hands HQ", gestada a partir de los gestos predefinidos que permiten los controladores en VRChat.

Hay dos aspectos principales que afectan a la forma en que se usa la lengua de signos en VR, el controlador y la mano dominante. Los controladores de Oculus Quest tienen botones, joystick, un agarre y un gatillo. Se detecta no solo que los presiones sino también que los toques.

VRChat aprovecha todo esto para permitir diversos gestos, como puedes ver en esta captura de mis manos en VRChat:

Vídeo 1: Gestos de las manos predefinidos en VRChat (con los controladores de Oculus Quest con mano dominante derecha)

La mano dominante es la responsable de la parte principal del signo, mientras que la mano de apoyo maneja cualquier función de signo secundario. También se usa a menudo para aclarar qué señal se está haciendo, especialmente en realidad virtual. En base a todo ello, se ha gestando la Lengua de Signos Estándar VR.

Imagen 1: Alfabeto en lengua de signos (estándar VR). Captura en el mundo "MrDummy_NL's Sign&Fun" de VRChat

En Devon's VRChat Sign Language Resource for Helping Hands se pueden consultar:

- los gestos disponibles según el controlador (Windows Mixed Reality, Oculus Touch (Rift CV1), Oculus Touch (Rift S / Quest), Vive Wands, Valve Index) y la mano dominante;

- referencia a varios mundos de VRChat, como MrDummy_NL's Sign&Fun y Helping Hands HQ, en los que aprender a comunicarte en Lengua de signos según este estándar (de ellos son mis capturas en este post);

- vídeos de cómo se dicen diversas palabras o expresiones. Por ejemplo, en el siguiente vídeo se indica cómo decir "Lunes" (se puede elegir inglés americano, inglés británico y alemán):

Vídeo 2: de https://vrsignlanguage.net/

A continuación incluyo varios vídeos de personas comunicándose en lengua se signos según el estándar VR. Tengo que decir que, después de investigar, memorizar y conseguir reproducir algunos de los gestos, me resulta admirable la destreza que reflejan y que es fruto de muchas muchas horas de práctica.

Vídeos de referencia:

Vídeo 3: Vídeo de YouTube "How to sign the alphabet in ASL in vrchat"

Vídeo 4: Vídeo de YouTube "Quest 2 Vs. Valve Index Hand Tracking For VRChat Sign Language"

Vídeo 5: Vídeo de YouTube "Meet the Helping Hands | VRChat (American Sign Language)"

Vídeo 1 e Imagen 1: Capturas con Oculus Quest por Olga Carreras en los mundos de VRChat MrDummy_NL's Sign&Fun y Helping Hands HQ.

Publicado el 5 de marzo de 2023.

Guía para personas ciegas y con baja visión en entornos de realidad virtual social

Una de las conferencias que más me ha gustado del XR Access Symposium 2023 es el estudio para integrar una guía en los entornos de realidad virtual social presentado por Crescentia Jung y Jazmin Collins de la Cornell University.

Los entornos de realidad virtuales sociales, como VRChat, RecRoom u Horizon, son espacios complejos y multiusuario. Las autoras proponen una guía que ayude a las personas ciegas y con baja visión a moverse por el espacio y que les dé información verbal para comprenderlo y realizar tareas. Para el estudio, se creó un entorno virtual social de prueba personalizado, donde los 16 participantes ciegos o con baja visión accedieron con unas Oculus 2. Los participantes podían agarrar objetos, moverse y teletransportarse.

La guía está inspirada en el mundo real, donde la persona con discapacidad visual se sitúa al lado y un poco detrás de la persona que le sirve de guía, con la mano en su codo.

Fuente de la imagen: Crescentia Jung y Jazmin Collins

En el proyecto, simularon la conexión física de una mano en el codo con retroalimentación háptica.

También crearon una función llamada "movimiento compartido". Cuando el participante está cerca de la guía y pulsa el botón de agarrar, se agarra a su codo y se colocan en la posición de guía, el participante al lado y un poco detrás. Participante y guía se mueven a la vez y, si el participante se teletransporta, lo hace con la guía.

Fuente de la imagen: Crescentia Jung y Jazmin Collins. La participante está al lado y detrás de la guía, sujetando su codo, y comparten movimiento.

En el estudio, la guía era una persona real, conectada desde otro lugar. Para su implementación real, se podría crear una red de amigos, o de voluntarios, como en "Be my eyes" o, en el futuro, pueden ser guías virtuales IA.

La guía tiene unas reglas de comportamiento. Para que los participantes controlen la experiencia, la guía no puede hacer sugerencia ni puede hacer acciones sin que el participante lo pida. Puede hacer preguntas abiertas "¿Qué te gustaría hacer?" o aclaratorias "¿Quieres decir que te lleve al río?". Puede responder preguntas sobre el espacio y llevar a cabo cualquier solicitud que el participante le haga sobre recoger o mover objetos. Tras la experiencia, se acordó que también debía advertir de peligros y obstaculos

En el estudio, se le pidió a los participantes que exploraran el parque en el que se ambienta el entorno de realidad virtual y que hicieran una búsqueda del tesoro recolectando objetos.

Como resultado general del estudio, los participantes pudieron describir con precisión el parque e interacturar y explorar el entorno con la guía. La mayoría completaron las tareas y dijeron que la guía les había resultado útil y que se habían sentido cómodos con ella. En la presentación se puede consultar algún vídeo de la interacción entre los participante y la guía.

Algunos participantes concebían a la guía como una herramienta, y sus solicitudes fueron utilitarias y muy directas. Otros, la concebían como un amigo, y se involucraban de manera más personal, llamándola por su nombre y queriendo incluirla a menudo en su experiencia.

Muchos participantes se sintieron apoyados y empoderados, seguros de poder contar con la guía cuando la necesitaran. Un grupo pequeño tuvo la impresión opuesta, la guía les hacía sentir dependientes, uno en concreto dijo que si fuera una IA no le haría sentir así.

En cuanto a la apariencia, la forma humana les pareció adecuada para entornos más formales, como reuniones virtuales o entornos de trabajo como Horizon. Sin embargo, en un entorno más informal, como en una fiesta VR, la guía humana podía reprimirles, obstaculizar su estilo o provocar que los demás se dirigieran a la guía en vez de al participante. Curiosamente, 4 de ellos, de forma independiente, propusieron en este contexto un loro al hombro. También se propuso que fuera invisible, que solo lo viera y oyera el usuario, de este modo, los presentes no sabrían que accedía con una herramienta de accesibilidad a menos que él lo revelara.

Uno de los desafios que quedó patente es que, aunque la guía puede guiarte hasta un lugar, por ejemplo una barandilla, no puede orientarte para que mires en la dirección correcta, debe hacerlo mediante información verbal.

Por otra parte, muchos participantes están nerviosos antes de acceder a la realidad virtual, les preocupa si van a saber interactuar o si se les va a olvidar cómo usar los controles. Esto es común a todos los que no están familiarizados con la tecnología, por ello, una guía puede ser de utilidad también para todo tipo de usuarios nóveles, un compañero social que te introduce en el entorno y refuerza tu confianza.

Por último, no se pueden obviar las cuestiones éticas. Si el guía es invisible, es injusto que los demás no sepan que hay alguien observando. La guía también podría escuchar información confidencial. Por ello, se podría incluir una opción para silenciar. También les preocupó el control que tienen sobre la guía, puesto que es una persona real, sobre su aspecto y sobre su comportamiento.

Nota junio 2024: en el congreso XR Access Symposium de 2024 han presentado su evolución, ahora es una guía IA capaz de describir el entorno, guiarte a tráves de objetos y poner balizas de audio. Explico todas las novedades en el artículo: "Design Interactive AI Visual Guides for Blind and Low Vision People"

Presentación de la conferencia: The guide has your back. Exploring how sighted guides can enhance accessibility in social VR for bling and low vision people

Resumen del proyecto:Sighted Guides to Enhance Accessibility for Blind and Low Vision People in VR

Publicado el 16 de junio de 2023.

Subtítulos y audiodescripciones

Hoy he asistido al webinar "Super accessibility: immersive media for all" de Pilar Orero de la UAB (Universitat Autònoma Barcelona) en la IAAP (International Association of Accessibility Professionals).

El webinar ha versado sobre su investigación durante los últimos 6 años con usuarios con discapacidad sobre accesibilidad en XR (Realidad Extendida). Todavía estoy dándole vueltas a muchas de las cosas que ha explicado, especialmente a las relacionadas con los subtítulos y la audiodescripción. Toda la problemática de dónde y cómo mostrar los subtítulos en 360º, especialmente cuando hay varias personas hablando, por ejemplo, para que no se solapen ni ocupen toda la pantalla, o para evitar las zonas periféricas, con peor visibilidad.

Ha referenciado un recurso muy interesante chxr.org, para la simulación de distintos tipos de subtítulos en 360 grados:

También me ha encantado su clasificación de los tres tipos de audiodescripción para personas con discapacidad visual: "tipo Dios" (desde el cielo), "tipo amigo" (desde encima de tu hombro) o desde la dirección de la acción.

Habrá que ponerse al día con sus publicaciones (Pilar Orero, publicaciones y proyectos)

Publicado en LinkedIn el 02 de marzo de 2023.

La importancia del contraste de las manos en XR

El proyecto "XR Barriers" de la BBC (2018-2020) se centró en recopilar datos sobre las barreras presentes en entornos de Realidad Extendida (XR) y cómo afectan a los usuarios. Para ello, trabajaron con más de 100 usuarios en 15 sesiones.

En total, recolectaron más de 1700 observaciones e identificaron 14 barreras comunes que afectan a los usuarios con discapacidades motoras, cognitivas y visuales dentro de las experiencias de XR.

En el estudio con usuarios con baja visión, el bajo contraste fue uno de los principales problemas que encontraron. El mayor impacto era que las manos tuvieran o no alto contraste, ya que son la llave para interactuar con el resto de elementos.

Imágenes capturadas con unas Oculus Meta Quest 2 por Olga Carreras.

Publicado en LinkedIn el 17 de febrero de 2023.

Migas de pan sonoras en Blind Burners de AltSpace

Las migas de pan sonoras y la verbalización de objetos son claves en la accesibilidad de los mundos de realidad virtual para las personas con discapacidad visual.

Blind Burners es un mundo de realidad virtual de AltSpace que se define como "un mundo diseñado para ser navegable sin el uso de la vista, brindando a los usuarios de realidad virtual con discapacidad visual un espacio para estar en Altspace. Con obras de arte de artistas con discapacidad visual, este mundo es un espacio para relajarse, bailar, conectarse y escuchar."

Una de las cosas que más me ha gustado de este mundo son las migas de pan formadas por sonidos en el camino, que te guían, y que se pueden observar en las imágenes que he capturado. En la primera imagen la miga de pan sonora me guía por un camino exterior del mundo; en la segunda me guía por una rampa al nivel superior de una edificación con obras de arte.

Imágenes capturadas con unas Oculus Meta Quest 2 por Olga Carreras.

Publicado en LinkedIn el 10 de febrero de 2023.

Seguimiento de manos en Meta Workrooms

Meta Workrooms te permite tener un despacho virtual en el que, gracias al escritorio remoto de Meta Quest, puedes acceder a la pantalla de tu ordenador; así como a una sala de reuniones, que cuenta con una pizarra. Al ser una aplicación de Meta, mantienes tu avatar. Desde un punto de vista de accesibilidad, el seguimiento de manos puede favorecer la comunicación mediante Lengua de Signos. En el vídeo se observa como en la realidad virtual mis brazos y los dedos de mis manos se mueven como en el mundo real. Sin embargo, Meta Workrooms todavía no admite subtítulos como en otros entornos.

Por otra parte, interactuar con las manos en vez de con los mandos, requiere poder realizar determinados gestos y bastante precisión manual, por lo que necesitamos que los botones sean grandes. En el vídeo se muestra que apuntar y pulsar un botón pequeño con la mano, como el de cerrar ventana, requiere precisión, igual que cuando accedes con el mando; o que se puede coger el mando al revés para escribir en la pizarra como si fuera un boli, acción que también requiere cierta destreza.

Vídeo capturado con unas Oculus Meta Quest 2 por Olga Carreras.

Publicado en LinkedIn el 7 de febrero de 2023.

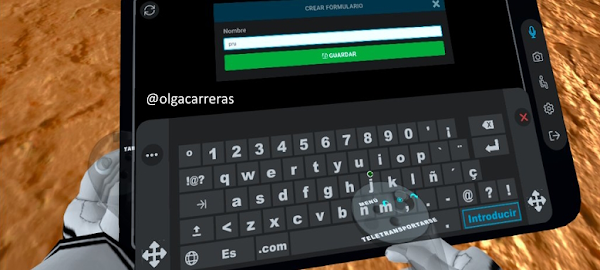

Formularios en VR

En el metaverso también hay formularios. Quizás no es lo que uno espera, pero así es. He publicado en el blog el artículo Accesibilidad de formularios en entornos de realidad virtual. Metaverso inclusivo".

En general, podemos aplicar todo lo que sabemos sobre accesibilidad y usabilidad en formularios web, pues parece que se está trasladando literalmente lo que conocemos a un entorno que es nuevo, diferente y que ofrece muchas más posibilidades.

Después de rellenar uno de estos formularios, siempre me pregunto cómo habríamos ideado la inclusión de esta información en el metaverso si no tuviéramos el bagaje de décadas de formularios web. Pero, de momento, es lo que hay.

En este artículo, todos los ejemplos son capturas de formularios en mundo virtuales que he realizado con unas Oculus Meta Quest 2.

Publicado en LinkedIn el 23 de marzo de 2023.

Características de accesibilidad de Cosmonious High

He publicado en el blog la reseña de las características de accesibilidad de Cosmonious High (Realidad Virtual).

El juego ofrece opcicones como:

- Subtítulos.

- Resalte de objetos.

- Descripción de objetos, de escenas y de opciones de teletransporte.

- Modo "Jugador sentado".

- Retroalimentación háptica y sonora.

- Textos, contraste de color y tamaño de los elementos.

Publicado el 28 de septiembre de 2023.

Opciones de accesibilidad en un laboratorio de química en Realidad Virtual (VR), accesibilidad en entornos de aprendizaje

Ayer (19/12/2023) asistí a la charla "The Challenges of Implementing Accessibility in a Digital Twin for Learning" (disponible en YouTube) de Christian Cousquer donde nos explicó cómo se ha desarrollado el laboratorio de química en Realidad Virtual (VR) del National Conservatory of Arts and Crafts de París, en el cual los alumnos pueden aprender en un entorno inmersivo y seguro a trabajar en un laboratorio.

En la charla explicó cómo se ha llevado a cabo el proyecto (desarrollado por Mimbus) y cómo integrarlo en el aula como refuerzo y/o como evaluación. Por ejemplo, nos comentó que usan un sistema de gestión de aprendizaje para VR llamado Mimbus Vulcan Competencies.

Me interesaba especialmente conocer las opciones de accesibilidad del entorno VR que habían creado, que son bastantes.

Podéis consultar la reseña completa en: Opciones de accesibilidad en un laboratorio de química en Realidad Virtual (VR), accesibilidad en entornos de aprendizaje

Publicado el 20 de diciembre de 2023.

Artículos de Olga Carreras sobre accesibilidad en VR (Realidad Virtual)

- General - Diferentes discapacidades

- Accesibilidad en XR, metaverso accesible e inclusivo. Guía de accesibilidad en entornos de Realidad Virtual (VR), 2022

- Ejemplos de opciones de accesibilidad en entornos de realidad virtual (VR) 2023. Metaverso accesible e inclusivo, 2023

- Accesibilidad de formularios en entornos de realidad virtual. Metaverso inclusivo, 2023

- Discapacidad auditiva

- Análisis de aplicaciones VR concretas

- Probando las características de accesibilidad de Cosmonious High (Realidad Virtual), 2023

- Opciones de accesibilidad en un laboratorio de química en Realidad Virtual (VR), accesibilidad en entornos de aprendizaje , 2023

- Viajar en Realidad Virtual. Opciones de accesibilidad. Metaverso y turismo inclusivo, 2024

- Reseñas de libros

- Cursos, ponencias, congresos